遥感技术在泰山区域矿山环境治理修复工程的监测应用

1

2019

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

遥感技术在泰山区域矿山环境治理修复工程的监测应用

1

2019

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于RS和GIS的浙江省矿山地质环境遥感监测

1

2020

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于RS和GIS的浙江省矿山地质环境遥感监测

1

2020

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

无人机遥感技术在北京首云铁矿储量动态监测中的应用

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

无人机遥感技术在北京首云铁矿储量动态监测中的应用

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

卫星遥感影像在稀土矿山动态监测研究

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

卫星遥感影像在稀土矿山动态监测研究

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于决策树分类的大屯矿区地物信息提取及矿区污染分析

1

2016

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于决策树分类的大屯矿区地物信息提取及矿区污染分析

1

2016

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

支持向量机(SVM)结合面向对象法在露天矿区信息提取中的应用研究

1

2017

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

支持向量机(SVM)结合面向对象法在露天矿区信息提取中的应用研究

1

2017

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

人工神经网络及其在遥感图像处理中的应用

1

2007

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

人工神经网络及其在遥感图像处理中的应用

1

2007

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于面向对象方法和多时相HJ-1影像的湿地遥感分类——以完达山以北三江平原为例

1

2012

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于面向对象方法和多时相HJ-1影像的湿地遥感分类——以完达山以北三江平原为例

1

2012

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

Object-based Change Detection

1

2012

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

Forest Change Detection by Statistical Object-based Method

1

2006

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于面向对象分类方法在SPOT影像中的地物信息提取

1

2011

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于面向对象分类方法在SPOT影像中的地物信息提取

1

2011

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于面向对象分类的稀土开采区遥感信息提取方法研究

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

基于面向对象分类的稀土开采区遥感信息提取方法研究

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

Urban Land-Use Mapping Using a Deep Convolutional Neural Network with High Spatial Resolution Multispectral Remote Sensing Imagery

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

An Object-based Convolutional Neural Network (OCNN) for Urban Land Use Classification

1

2018

... 目前,现有遥感影像露天开采区提取方法主要分为人工方法和传统遥感自动提取方法.人工方法主要采用遥感目视解译对露天开采区进行信息提取和监测[1,2,3].目视解译方法能够精确地提取露天开采区边界,但需要解译人员具有一定的遥感判读经验,主观性较强,且工作效率低.传统遥感自动分类的露天开采区提取方法主要分为基于像元分类的提取方法和面向对象分类的提取方法.基于像元分类的露天开采区提取的常用方法包括最大似然法[4]、决策树分类法[5]、支持向量机分类法[6]以及神经网络分类法[7],这些方法因主要利用遥感影像不同波段所携带的光谱信息,没有考虑对象的空间、纹理等信息[8],无法从整体上解译影像的特征,导致这些方法对于露天开采区的提取效果并不理想,并会产生信息冗余和大量的“椒盐”现象[9,10].针对这些问题,许多研究者提出了运用面向对象的分类方法对露天开采区进行提取[11,12],该分类方法综合利用遥感影像的光谱特征和形状特征,可以避免常规基于像元分类方法导致的“椒盐”现象,获得更高的精度.但是面向对象的方法需要人为确定分类规则,对于边界比较模糊的露天开采区,提取结果很大程度上取决于分类规则的准确性,受人的主观因素影响较大[13],人机交互工作量大;另一方面,该方法应用于不同传感器、不同分辨率的多源遥感影像往往需要设定不同的分类规则,很难获得不同类型的露天开采区特征,这使得面向对象的分类方法通用性不强,泛化性较差,很难适应于不同来源的遥感影像露天开采区提取[14]. ...

Using Convolutional Neural Networks Incorporating Hierarchical Active Learning for Target-searching in Large-scale Remote Sensing Images

1

2020

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

A Novel Approach to Use Semantic Segmentation based Deep Learning Networks to Classify Multi-Temporal SAR Data

1

2020

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

Multi-Scale DenseNets-based Aircraft Detection from Remote Sensing Images

1

19

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

Deep Learning for Remote Sensing Data: A Technical Tutorial on the State of the Art

1

2016

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

Vehicle Detection in Satellite Images by Hybrid Deep Convolutional Neural Networks

1

11

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

全卷积神经网络用于遥感影像水体提取

1

2018

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

基于改进的全卷积神经网络的资源三号遥感影像云检测

1

2019

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

基于改进的全卷积神经网络的资源三号遥感影像云检测

1

2019

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

Building Extraction in Very High Resolution Remote Sensing Imagery Using Deep Learning and Guided Filters

1

2018

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

Classification for High Resolution Remote Sensing Imagery Using a Fully Convolutional Network

2

2017

... 近年来,将人工智能深度学习应用于遥感图像信息提取成为新的技术趋势[15,16,17],深度学习提供了一种从训练集中自动学习有效特征的方法[18].它能够从非常大的原始图像数据集中进行无监督的特征学习[19].王雪等[20]利用带密集连接的全卷积神经网络,实现了对遥感影像水体提取,并与传统的基于影像光谱特征的阈值法和基于图论的GrabCut算法进行比较,证明全卷积神经网络水体提取模型具有更好的稳健性和泛化性.斐亮等[21]为实现对资源三号卫星云区的检测和提取,改进了vgg16网络结构,结果表明,改进后的网络结构在云区检测精度和速度上均优于传统云区检测方法.Xu等[22]提出了一种遥感城市建筑物提取Res-U-Net网络模型,在数据预处理阶段使用边缘增强,并引进导向滤波,优化了分类结果并去除了“椒盐”类噪声.Fu等[23]在全卷积神经网络基础上,引入了Atrous卷积和跳层结构,并使用条件随机场(CRF)细化输出类映射,该模型对于多分辨率影像(高分二号和IKONOS真彩色影像)的分类具有很强的适用性和准确性. ...

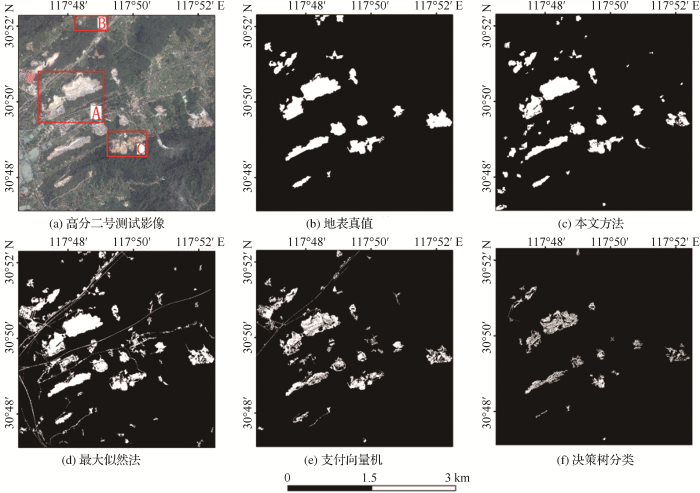

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

结合均值漂移分割与全卷积神经网络的高分辨遥感影像分类

1

2018

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

结合均值漂移分割与全卷积神经网络的高分辨遥感影像分类

1

2018

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

An Improved Method for Road Extraction from High-resolution Remote Sensing Images that Enhances Boundary Information

1

2020

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

Automatic Semantic Segmentation with DeepLab Dilated Learning Network for Change Detection in Remote Sensing Images

1

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

Deep Multi-feature Fusion Network for Remote Sensing Images

1

2020

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

Classification with an Edge: Improving Semantic with Boundary Detection

1

135

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

Very High Resolution Urban Remote Sensing with Multimodal Deep Networks

1

2018

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

A Multiple-feature Reuse Network to Extract Buildings from Remote Sensing Imagery

1

2018

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

doi:10.1109/CVPR.2017.243

1

06993

... 全卷积神经网络是深度学习模型在二维特征提取上的核心,它采用卷积层替代全连接层,通过反卷积对最后一个卷积层特征图进行上采样,恢复到与输入图像相同的大小,从而可以对每个像素产生概率预测,最后在反卷积特征图上比较每个类别的概率,从而逐像素进行分类[24].全卷积神经网络有效利用图像底层特征,加强了图像的深度特征提取,从而提高了网络效率和识别精度,基于全卷积神经网络的遥感图像信息提取模型已经成为当前遥感图像深度学习信息提取的主流方法[25,26,27,28,29,30,31]. ...

In The One Hundred Layers Tiramisu: Fully Convolutional Densenets for Semantic Segmentation

1

2017

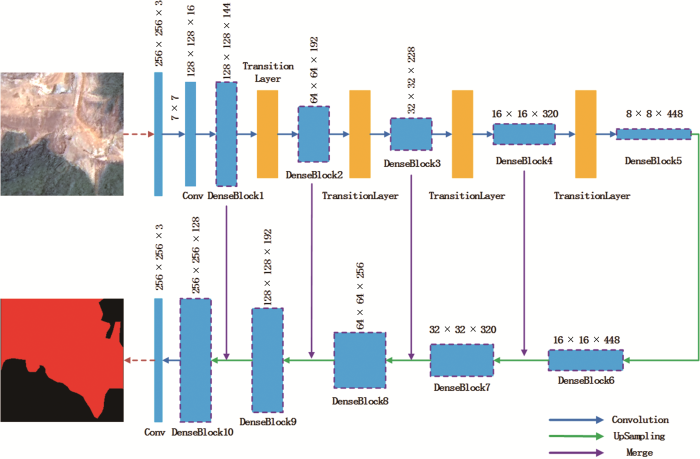

... 为了有效保持前馈性质、最大程度地传递全卷积神经网络中两个层之间的信息流,Simon等[32]提出了密集连接块(DenseBlock)的概念,它不是在特征传递到层之前通过求和来组合特征,而是通过密度连接的方式将每个前面层的自身特征叠加映射传递给所有后续层,以实现将所有前面层直接连接、获取组合特征.这种密集的连接模式就称为密集连接块,其公式表达为: ...

Road Extraction from High-Resolution Remote Sensing Imagery Using Deep Learning

1

2018

... 将密集连接的思想引入全卷积神经网络,就称为密集连接全神经网络(DenseNet),它缓解了梯度消失的问题,并加强了特征传播、大大减少了参数的数量,由于它具有强大的特征抽取和复用能力,DenseNet网络被认为非常适用于遥感影像的信息提取[33,34]. ...

Building Extraction in Very High Resolution Remote Sensing Imagery by Dense-Attention Networks

1

2018

... 将密集连接的思想引入全卷积神经网络,就称为密集连接全神经网络(DenseNet),它缓解了梯度消失的问题,并加强了特征传播、大大减少了参数的数量,由于它具有强大的特征抽取和复用能力,DenseNet网络被认为非常适用于遥感影像的信息提取[33,34]. ...

1

2013

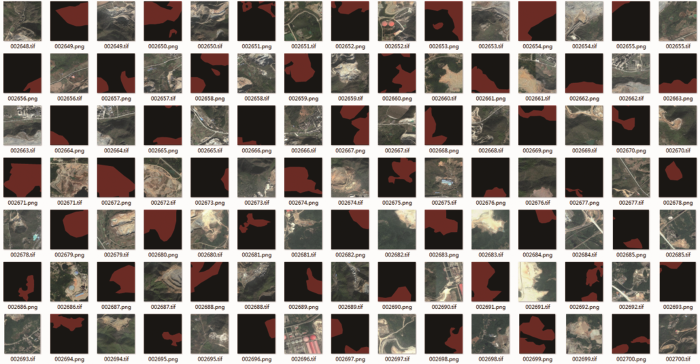

... 选用了不同年限、不同季节的高分一号影像12景,高分二号影像6景和Google Earth影像10景.考虑到开采区边界的模糊性,将样本数据分为露天开采区、疑似露天开采区和背景3类,疑似开采区样本可以减少类似地物对露天开采区提取结果的影响.由于遥感影像数据量大,难以直接将整幅遥感影像输入到网络中进行训练,因此,需要对遥感影像进行多尺度分割.此外,多尺度分割还有利于增加训练样本的数量和多样性,以防止模型的过拟合问题.针对样本制作的需要,本文利用Python语言,设计并开发了一套自动化的遥感影像训练样本库制作工具.按照文献[35]中“露天采掘场”遥感目视解译要求采集样本(即遥感影像和与之匹配的露天开采区矢量数据)作为数据输入,该工具可全自动化地将目视解译样本转换为模型训练所需的样本格式(即栅格标签样本格式,如图2). ...

1

2013

... 选用了不同年限、不同季节的高分一号影像12景,高分二号影像6景和Google Earth影像10景.考虑到开采区边界的模糊性,将样本数据分为露天开采区、疑似露天开采区和背景3类,疑似开采区样本可以减少类似地物对露天开采区提取结果的影响.由于遥感影像数据量大,难以直接将整幅遥感影像输入到网络中进行训练,因此,需要对遥感影像进行多尺度分割.此外,多尺度分割还有利于增加训练样本的数量和多样性,以防止模型的过拟合问题.针对样本制作的需要,本文利用Python语言,设计并开发了一套自动化的遥感影像训练样本库制作工具.按照文献[35]中“露天采掘场”遥感目视解译要求采集样本(即遥感影像和与之匹配的露天开采区矢量数据)作为数据输入,该工具可全自动化地将目视解译样本转换为模型训练所需的样本格式(即栅格标签样本格式,如图2). ...

Fusion of LiDAR and Imagery for Reliable Building Extraction

1

2008

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

Automatic Building Footprint Extraction from High-resolution Satellite Image Using Mathematical Morphology

1

2018

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

Quality Assessment for Geo-spatial Objects Derived from Remotely Sensed Data

1

2005

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

Using the Dempster–Shafer Method for The Fusion of LiDAR Data and Multi-Spectral Images for Building Detection

2

2005

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

... 由于遥感影像露天开采区边界较模糊,内部构成比较复杂,使用单一精度评价方法难以准确评价模型精度,因此需要综合考虑现有评价方法特点.现有的基于对象的评价方法通常适用于图像二分类识别,例如用于计算召回率(Recall)的参数,TP表示被正确识别的正样本个数,FN是被正确识别的负样本个数,将此直接应用于影像目标提取,由于无法统计背景个数,即无法得到被正确识别的负样本个数FN.因此,需要将召回率(Recall)重新定义为正确提取个数(TP)与真实目标个数(TP+FN)的比值.本文采用的精度评价指标及其含义详见表2.(注:本文只将提取结果与地表真值的重叠面积达到50%以上的目标统计为正确提取数目[39,43]). ...

Development of Comprehensive Accuracy Assessment Indexes for Building Footprint Extraction

1

2005

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

Status of Land Cover Classification Accuracy Assessment

1

2002

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

A Comparison of Evaluation Techniques for Building Extraction from Airborne Laser Scanning

1

2009

... 对于深度学习模型影像信息提取精度的评价,目前主要基于像元的评价方法[23,36]和基于对象的评价[37,38,39]方法两个方面进行.基于像元的评价方法是通过评估提取目标的像素数量,反映提取结果在几何精度和形状相似性方面的吻合程度[40],但可能存在因提取结果与地表真值之间像元未严格匹配而产生偏差的问题,严重影响精度评价的准确性[41].基于对象的评价方法避免了像元偏差误差,量化了提取目标的数量,评价结果可以与提取目标重要的参数相互关联,从而可以分析目标错误提取的潜在原因[42],但其受人为主观影响较大,使得漏警率和虚警率的准确性较差,同时也无法反映提取结果的整体性、几何精度和形状相似性. ...

An Automatic and Threshold-free Performance Evaluation System for Building Extraction Techniques from Airborne LiDAR Data

1

2014

... 由于遥感影像露天开采区边界较模糊,内部构成比较复杂,使用单一精度评价方法难以准确评价模型精度,因此需要综合考虑现有评价方法特点.现有的基于对象的评价方法通常适用于图像二分类识别,例如用于计算召回率(Recall)的参数,TP表示被正确识别的正样本个数,FN是被正确识别的负样本个数,将此直接应用于影像目标提取,由于无法统计背景个数,即无法得到被正确识别的负样本个数FN.因此,需要将召回率(Recall)重新定义为正确提取个数(TP)与真实目标个数(TP+FN)的比值.本文采用的精度评价指标及其含义详见表2.(注:本文只将提取结果与地表真值的重叠面积达到50%以上的目标统计为正确提取数目[39,43]). ...